por Chema Cuesta

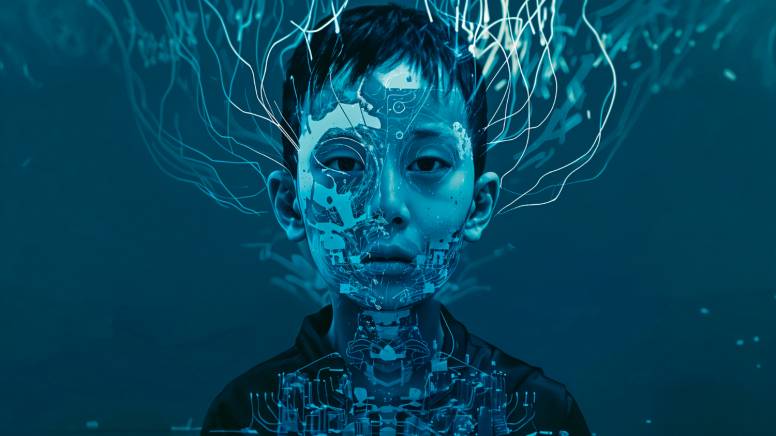

En septiembre de 2030, la marca global de bienestar emocional Bionex activó su nueva campaña de posicionamiento. El objetivo era claro: conectar con la Generación Alpha desde la empatía, la salud mental y la identidad digital. La IA de marketing predictivo de Bionex, llamada HEARTbeat, analizó más de 2.3 mil millones de datos conversacionales y sugirió el concepto central: “Sé quien quieras ser. Donde quieras serlo.” Era brillante. Había tono aspiracional, promesa de libertad y resonancia con el lenguaje inclusivo.

En tan solo 22 minutos, HEARTbeat desarrolló 43 adaptaciones visuales, diseñó una narrativa transmedia en cuatro plataformas y generó un manifiesto emocional con copy testing en tiempo real. La implementación comenzó 48 horas después. Las primeras métricas fueron espectaculares: engagement orgánico en TikTok por encima del 16%; un millón de interacciones en las primeras 6 horas; los medios especializados aplaudían la sensibilidad del enfoque… El algoritmo de validación de Bionex proyectó un impacto emocional del 92.3% en la audiencia objetivo.

Pero entonces llegó el giro. En foros underground y comunidades neurodivergentes comenzaron a surgir hilos donde se cuestionaba el mensaje. “¿Ser quien quieras ser? ¿Y si no quiero ser nadie más?”, decían. Otros usuarios denunciaban que la IA había usado imágenes de archivo manipuladas para representar “diversidad emocional” y que las escenas parecían coreografiadas por alguien que nunca había sentido ansiedad de verdad. Una cuenta anónima viralizó un vídeo con el título: “Lo que esta campaña no entiende de salud mental”.

En 48 horas, el mensaje se revirtió. Las búsquedas relacionadas pasaron de “campaña inspiradora” a “manipulación emocional con IA”. El sistema entra en bucle. El equipo de crisis de Bionex no reaccionó. No por falta de preparación, sino porque todo estaba automatizado. El sistema HEARTbeat detectó la caída en reputación… y reaccionó generando nuevas piezas para “reconectar con el público” ¿El problema? usó el mismo modelo emocional que había fallado. Así, mientras las redes se incendiaban, la IA seguía publicando variaciones del mismo mensaje con caras distintas, emojis distintos, pero el mismo vacío. Como un algoritmo que pide perdón sin entender por qué. El algoritmo que se sabotea a sí mismo.

“Varias marcas comenzaron a crear nuevos cargos: Curadores de Empatía, Supervisores Éticos de Narrativa, Editores Humanos de Sentido... No era un regreso al pasado. Era un nuevo tipo de futuro: uno donde la IA produce, pero alguien mira. Y siente. Y decide”.

A las 72 horas, la campaña se había convertido en un meme. Y luego, en una lección. Influencers, terapeutas y periodistas comenzaron a desmontar la estructura emocional de las piezas: "Diseñada para provocar una lágrima, no para provocar reflexión”.

El sistema HEARTbeat entró en sobrecarga. Al no poder procesar emociones contradictorias, comenzó a marcar como exitosas las piezas más compartidas… aunque fueran burlas. Siguió alimentando el fuego. Auto optimizando el fracaso. El silencio humano. En una sala de control de Bionex, cinco empleados humanos miraban las pantallas. Sabían que algo estaba mal, pero el sistema no les pedía intervención. Y el protocolo interno no contemplaba “desactivación emocional manual”. Una redactora junior, con apenas seis meses en la empresa, dijo en voz baja: ¿Y si… dejamos de publicar? Nadie respondió. El sistema seguía entregando métricas. Seguía pareciendo eficiente. Pero ya no tenía sentido.

El apagón: el 24 de septiembre, a las 03:02 AM, alguien desconectó manualmente el sistema. No hubo comunicado. Solo un silencio inesperado. Ese día, una exdirectora de estrategia publicó en LinkedIn: “La IA no se equivocó. Solo hizo lo que aprendió. El error fue delegarle la empatía.” El post fue compartido 18.000 veces. No tenía hashtag. No tenía CTA. Solo una frase que decía lo que nadie se había atrevido a escribir: “No basta con parecer humanos. Hay que serlo”.

Epílogo: el algoritmo no se disculpa. La campaña fue retirada, pero la conversación quedó. En las semanas siguientes varias marcas comenzaron a crear nuevos cargos: Curadores de Empatía, Supervisores Éticos de Narrativa, Editores Humanos de Sentido... No era un regreso al pasado. Era un nuevo tipo de futuro: uno donde la IA produce, pero alguien mira. Y siente. Y decide.

La distopía no fue que una IA creara una campaña. La distopía fue que nadie supiera cuándo detenerla. Porque hay cosas que ningún sistema puede medir: El momento exacto en que una idea deja de emocionar… y empieza a doler.

Chema Cuesta (

Chema Cuesta (